Interstellar Group versterkt positie op de data- en AI-markt met overname Den of Data

Delft, 1 april 2025 – Geen grap, maar een serieuze stap vooruit: de Interstellar Group breidt haar expertise in data en AI verder uit met de overname van Den of Data. Met deze overname voegt de Interstellar Group een gespecialiseerd team van data-experts toe aan haar groeiende collectie gespecialiseerde IT-bedrijven. Hiermee versterkt de Interstellar Group haar positie in data en AI.

Data en AI bepalend voor de toekomst:

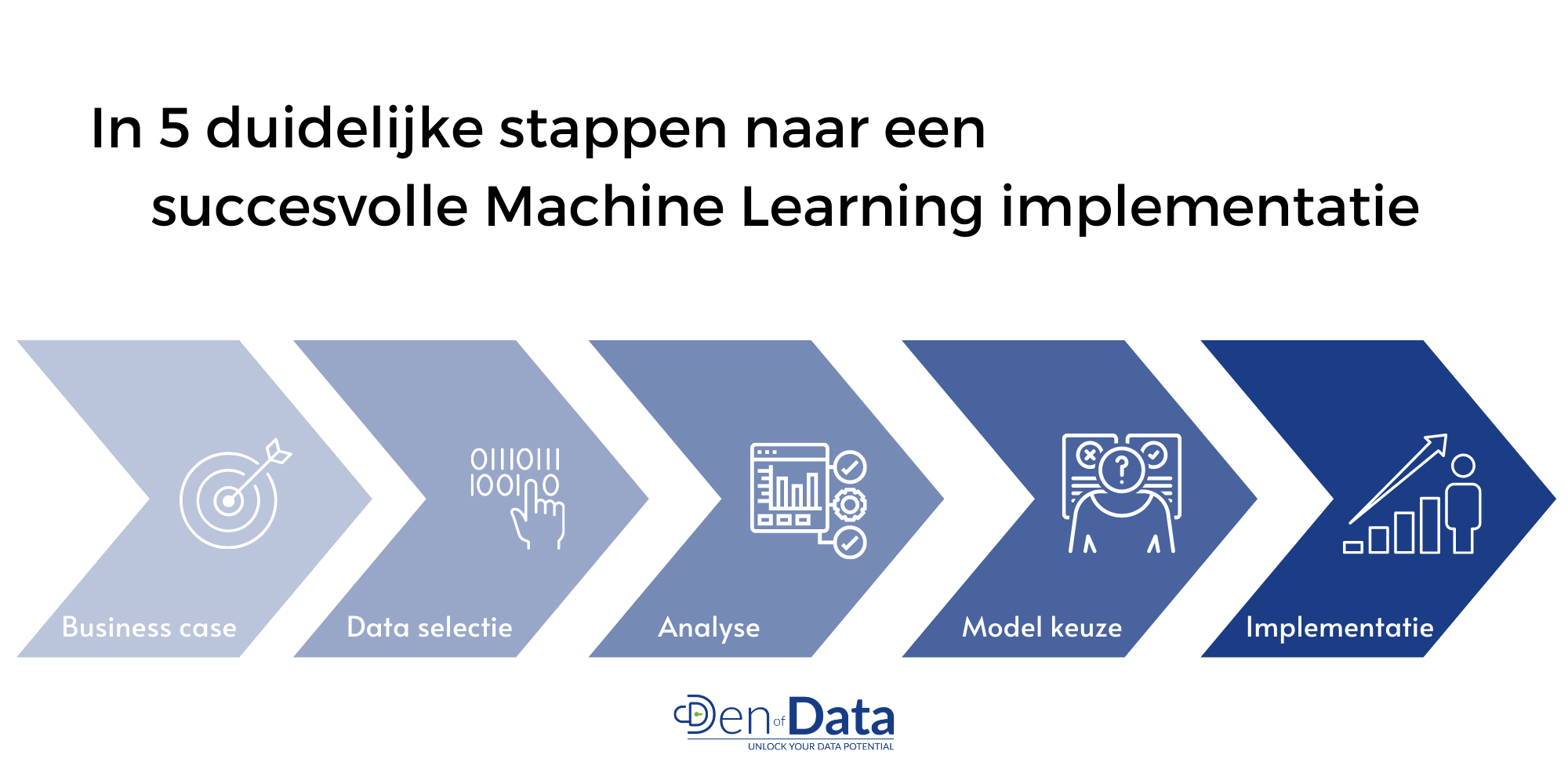

De overname past binnen de strategie van de Interstellar Group om dit jaar volop in te zetten op data en AI en zo klanten beter te ondersteunen bij digitale transformaties. Den of Data is een vooraanstaande speler in data-analyse, datagedreven optimalisatie en AI-oplossingen en helpt organisaties bij het ontsluiten van de waarde van hun data, waardoor processen efficiënter worden.

Maarten van Montfoort, CEO van de Interstellar Group, zegt over de overname: “Data en AI zijn cruciale pijlers voor de toekomst van IT en bedrijfsinnovatie en dat zien we terug in de vraag vanuit de markt. Met de expertise van Den of Data versterken we onze propositie en kunnen we onze klanten nog beter ondersteunen in het juist inzetten van data.”

Blijvende focus op Microsoft-first strategie:

De overname van Den of Data sluit perfect aan op de recent gelanceerde Data & AI Tribe van RawWorks binnen de Interstellar Group. Waar de Data & AI Tribe zich richt op advies, strategie en implementatie van geavanceerde AI-oplossingen binnen bedrijven, brengt Den of Data aanvullende specialisatie in dataplatformen, data-analyse, AI-modellering en procesoptimalisatie mee. Bovendien sluit de expertise van Den of Data naadloos aan op de Microsoft-first strategie van de Interstellar Group; diepgaande kennis van het Microsoft-data-ecosysteem en het zelf ontwikkelde dataplatform van Den of Data helpen bedrijven om datagedreven beslissingen te nemen.

Douwe van Dijk, oprichter en Managing Director bij Den of Data, zegt: “Vijf jaar geleden zijn we begonnen aan de keukentafel en nu zijn we klaar voor de volgende stap. In deze relatief korte periode hebben we met ons team een snelle groei gerealiseerd. We kijken ernaar uit om nog meer waarde toe te voegen en potentieel te realiseren met Interstellar en de overige vijf bedrijven binnen de groep.

Pieter de Graaf, oprichter en Data Platform Architect bij Den of Data vult aan: “De ambities van de Interstellar Group sluiten naadloos aan op die van Den of Data en bieden onze klanten meer mogelijkheden op het gebied van productiviteit, infrastructuur en cybersecurity.”

Over de Interstellar Group:

Met een focus op productiviteit, infrastructuur en security ondersteunt de Interstellar Group middelgrote organisaties bij het verbeteren en stabiliseren van hun IT-omgevingen. Het bedrijfsmodel van de Interstellar Group is uniek.

De IT Services Provider bestaat uit een managed services provider (MSP) onder de naam Interstellar en vier specialistische IT-bedrijven: Pinewood, EightFence (cybersecurity), RawWorks (productiviteit) en Fundaments (soevereine cloud). Den of Data (Data & AI) zal aan hier als vijfde organisatie aan worden toegevoegd.

Deze vier organisaties opereren als autonome, strategische partners die toegevoegde waarde bieden aan zowel hun eigen klanten, als die van de MSP Interstellar. Door het samenbrengen van managed services en unieke, individuele expertise, worden waardevolle combinaties gecreëerd. Met maatwerk voor iedere klant. Sinds de oprichting in 2021, als onderdeel van investeringsmaatschappij Quadrum Capital werkt de Interstellar Group met ruim 800 medewerkers vanuit elf locaties door het hele land.

Voor meer informatie, kijk op Interstellar.nl of op LinkedIn.